验证PySpark安装

PBLP平台中内置已经配置好了PySpark环境。可以直接使用PySpark,不需要像Hadoop一样运行启动命令。下面我们通过运行PySpark自带的蒙特卡罗求圆周率π值示例,以验证Spark是否安装成功。

PySpark支持以本地模式运行PySpark程序,或者以集群模式运行PySpark程序。

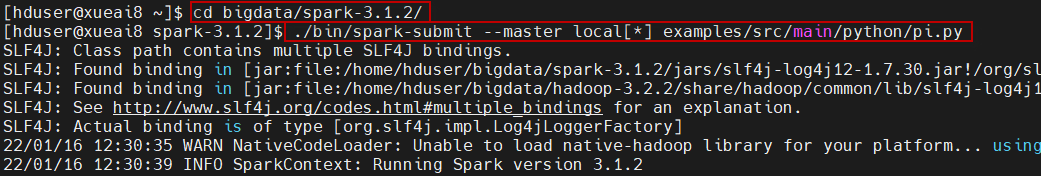

在本地(Local)模式下,进入到Spark主目录下,直接使用spark-submit命令来提交示例程序pi.py运行即可。命令如下:

$ cd ~/bigdata/spark-3.1.2 $ ./bin/spark-submit --master local[*] examples/src/main/python/pi.py

执行过程如下所示:

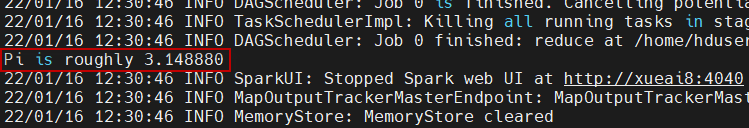

执行结果如下图中所示:

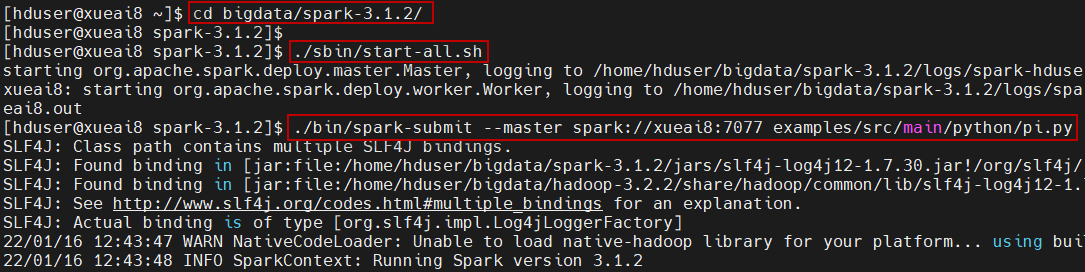

或者,也可以使用standalone模式(需要先执行./sbin/start-all.sh启动Spark集群):

$ cd ~/bigdata/spark-3.1.2 $ ./sbin/start-all.sh $ ./bin/spark-submit --master spark://xueai8:7077 examples/src/main/python/pi.py

说明:

- --master参数指定要连接的集群管理器,这里是standalone模式。

- 最后一个参数是所提交的python程序。

执行过程如下所示:

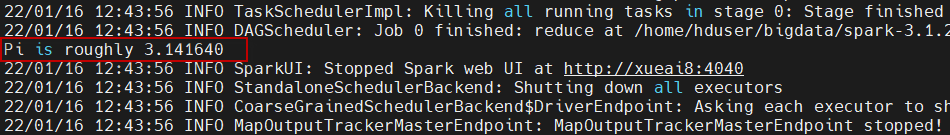

执行结果如下图中所示:

如果以上一切正常,那么说明你的PySpark环境是正确的,可以使用。